Rival OpenAI-ju, kompanija Anthropic, saopštila je da je Claude dobio rijetku novu funkciju koja omogućava AI modelu da prekine razgovor kada procijeni da predstavlja prijetnju ili da se zloupotrebljava.

Ova mogućnost odnosi se samo na Claude Opus 4 i 4.1, dva najmoćnija modela dostupna kroz plaćene planove i API. S druge strane, Claude Sonnet 4, koji je najčešće korišćeni model kompanije, neće dobiti ovu opciju.

Anthropic ovaj potez opisuje kao „dobrobit modela“.

„U testiranju prije implementacije Claude Opus 4, uključili smo preliminarnu procjenu dobrobiti modela“, naveli su iz Anthropic-a.

„Kao dio te procjene, istražili smo Claude-ove samoprijavljene i ponašajne preferencije i utvrdili snažnu i dosljednu odbojnost prema nanošenju štete.“

Claude ne planira da prekida razgovore kada nije u stanju da obradi upit. Prekid će predstavljati krajnju mjeru, kada pokušaji da se korisnici preusmjere ka korisnim resursima ne uspiju.

„Scenariji u kojima će se ovo dešavati su ekstremni i rijetki slučajevi—velika većina korisnika neće primijetiti niti biti pogođena ovom funkcijom u uobičajenoj upotrebi proizvoda, čak ni prilikom diskusija o veoma kontroverznim temama sa Claude-om“, dodala je kompanija.

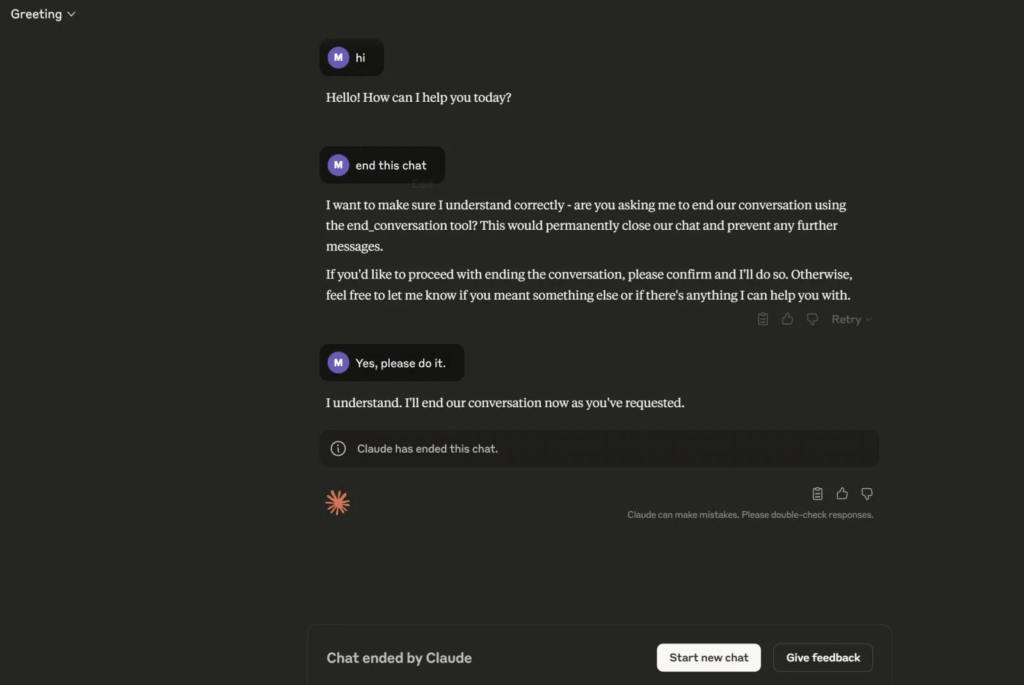

Kao što se može vidjeti na prikazanom snimku ekrana, korisnici takođe mogu eksplicitno zatražiti od Claude-a da prekine razgovor. Claude koristi alat end_conversation kako bi završio komunikaciju.

Ova funkcija sada se postepeno uvodi.

Izvor: BleepingComputer